Le succès de ChatGPT est indéniable. Avec plus de 100 millions d’utilisateurs, même OpenAI est étonné de ce que le modèle d’intelligence artificielle a accompli en quelques mois. Que ce soit par la polyvalence de ses domaines d’intervention, la qualité de ses réponses et la variété de ce qu’il peut faire, ce modèle de langage est salué par tout le monde, Elon Musk et Bill Gates, y compris. Depuis, le nombre d’utilisateurs s’accroît chaque semaine et plusieurs entreprises l’intègrent à leur fonctionnement. Cependant, ChatGPT est encore limité. Voici 6 de ses limites.

Sommaire :

ChatGPT ne peut pas fournir des informations sur les évènements récents

C’est un sujet qui revient souvent et OpenAI donne un avertissement à cet effet sur la page d’accueil. ChatGPT a une base de données qui se limite à 2021. Si vous lui posez des questions, il est possible que les réponses qu’il vous apporte ne soient pas à jour. D’ailleurs, si vous spécifiez l’année 2022 ou 2023 dans votre réponse, l’IA vous informera qu’elle est limitée aux événements de 2021.

Toutefois, il existe de nombreuses extensions pour Chrome qui vous permettent de naviguer sur internet pour trouver les infos récentes dont vous pourriez avoir besoin.

Par ailleurs, Bard, l’IA de Google qui est actuellement en bêta test est connectée à internet. Ceci lui offre un avantage certain sur son concurrent.

Les informations que fournies ChatGPT ne sont pas toujours vraies

Bien que ChatGPT soit connu pour ses performances et l’exactitude de certaines de ses réponses, il est recommandé de prendre des pincettes. Il arrive que l’IA soit victime d’hallucination et donner des réponses inexactes. Le plus souvent, celles-ci concernent des citations d’auteurs, des passages de livres ou des faits historiques.

Par exemple, on lui a demandé de dire ce qu’il sait sur Ole Gunnar Solksjaer. Dans sa réponse, ChatGPT dit que l’entraîneur de Manchester United avait remporté la Ligue Europa en 2018.

«Sous la direction de Solskjaer, Manchester United a gagné la Ligue Europa en 2020. Solskjaer est connu pour son style de jeu offensif et son accent mis sur la promotion des jeunes joueurs de l’académie du club.»

Pourtant, l’entraîneur n’a absolument gagné aucun trophée avec le club. Ce n’est qu’en 2021 qu’il atteint la finale de la Ligue Europa. Finale perdue aux tirs au but contre le FC Séville.

VOIR AUSSI : Apple : la course à l’IA est peut-être lancée avec le rachat de cette start-up

ChatGPT ment parfois sur les sujets pointus

De l’avis de plusieurs experts, ChatGPT a encore du chemin à se faire pour être reconnu comme spécialiste. Même s’il est capable de faire dissertation, l’IA est beaucoup limitée lorsqu’il faut entrer dans des détails pour prouver la véracité de ce qu’elle a dit. C’est notamment le cas lorsqu’il s’agit des mathématiques où l’IA commet souvent des erreurs grossières dans ses démonstrations ou encore dans le domaine médical. Ceci étant, si vous avez des sujets qui consistent à faire des démonstrations, il vaudrait peut-être mieux de faire travailler votre cerveau.

Une limite que reconnaît Sam Altman lui-même, PDG d’OpenAI : « ChatGPT est incroyablement limité, mais suffisamment bon dans certains domaines pour donner une impression trompeuse de grandeur. C’est une erreur de s’y fier pour quoi que ce soit d’important pour le moment. Il s’agit d’un aperçu des progrès réalisés ; nous avons encore beaucoup de travail à faire en matière de robustesse et de véracité. ».

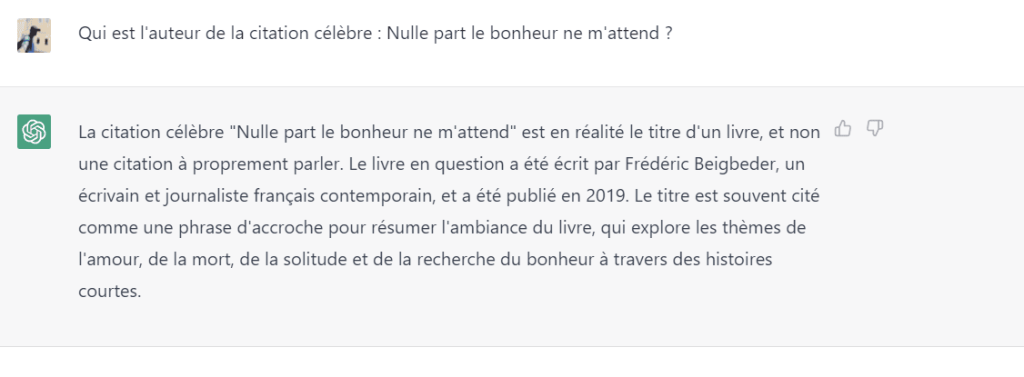

Même sur des sujets simples, ChatGPT peut vous induire en erreur. C’est l’exemple de cette conversation que j’ai eu avec lui. Je lui demande l’auteur de la citation d’Alphonse Lamartine : Nulle part le bonheur ne m’attend. Malgré ma précision, il m’assure qu’il s’agit d’un livre, ce qui est faux !

Les contenus de ChatGPT sont peu personnalisés

Dans les faits, ce n’est pas un problème propre à ChatGPT. C’est une insuffisance à tous modèles d’IA qui sont actuellement sur le marché. Comme elles, ChatGPT ne personnalise pas son contenu, ne s’imprègne pas des textes qu’il rédige.

Lorsqu’on lui demande de produire un texte, on y voit d’emblée l’âme d’une personne distante de son œuvre, froide et impersonnelle.

Ceci étant, si vous travaillez avec ChatGPT, vous devez prendre le temps de retravailler le contenu produit. Et parfois, cela peut être encore plus fastidieux.

ChatGPT ne fournit pas de sources

Si vous avez besoin de faire des travaux universitaires, journalistiques ou toute autre recherche dans laquelle vous avez besoin de citer vos sources, ChatGPT n’est sans doute pas la meilleure solution.

Pour vous répondre, l’IA ne prend pas toutes ses informations en un endroit. Il recoupe ici et là dans sa base de données composée d’articles de journaux, livres, vidéos, contenus du web, etc. Une variété de sources que ChatGPT ne cite malheureusement pas. En revanche, vous pouvez utiliser Bing Chat.

ChatGPT est dépourvu d’émotions

Les robots et autres programmes informatiques ne peuvent pas ressentir d’émotions. En conséquence, ils ne font pas toujours la différence entre l’humour et le sarcasme. Cela les empêche aussi de faire preuve d’esprit critique dans certaines situations données. C’est pourquoi ChatGPT essaie le plus possible de nuancer les réponses qu’il donne. Ou encore, il a du mal à hiérarchiser les différentes parties des contenus qu’il propose.